גוגל פרסמו מדריך חדש לניהול תקציב סריקה באתרים גדולים. המדריך סוקר את כל הדרכים שבהן אפשר לייעל את תקציב הסריקה של גוגל ולגרום לגוגלבוט לסרוק כמה שיותר דפים רלוונטיים.

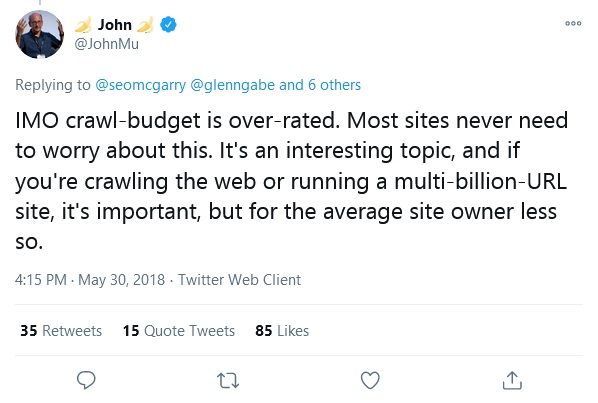

רוב האתרים לא צריכים לדאוג לגבי תקציב הסריקה, לפי ג'ון מולר, אנליסט בכיר בגוגל. אבל עבור אתרי קניות המכילים מיליוני דפי מוצרים, קטגוריות, קטגוריות משנה, סיווגים, מדריכים ועוד, מדיניות סריקה לא יעילה יכולה לפגוע בפוטנציאל התנועה מגוגל. אז מה המשמעות של תקציב סריקה ואיך אפשר לנהל אותה בדרך שתתמוך בקידום האתר בגוגל?

מהי ההגדרה של אתרים גדולים?

המדריך של גוגל מיועד לאתרים משני סוגים:

– אתרים בעלי יותר ממיליון דפים ייחודיים המתעדכנים בקצב ממוצע של אחת לשבוע (למשל, אתרי קניות).

– אתרים בעלי 10,000 דפים או יותר המתעדכנים בקצב מהיר (למשל, אתרי חדשות).

כאמור, עבור אתרים בהיקפים קטנים יותר, תקציב הסריקה ממלא תפקיד זניח בקידום האתר בגוגל.

איך מחושב תקציב הסריקה של גוגל?

אפילו גוגל לא יכולים לסרוק את כל הדפים באינטרנט. לכן, הם מקציבים לכל אתר זמן ומשאבים מוגבלים. הקצבה זאת מכונה "תקציב סריקה" והיא נקבעת לפי שני גורמים עיקריים: קיבולת הסריקה והביקוש לסריקה.

קיבולת הסריקה – המטרה של גוגל היא לסרוק כמה שיותר דפי אתר בלי להכביד על השרתים. לכן, לכל אתר נקבעת מגבלה על קיבולת הסריקה. המגבלה הזאת נקבעת לפי המספר המקסימלי של חיבורים שיכולים להיסרק בו זמנית, ולפי הפרשי הזמן בין אחזורים של דפי האתר. מגבלת קיבולת הסריקה יכולה לעלות או לרדת לפי כמה מדדים:

- תקינות – באתר בריא ומהיר המגבלה תעלה, ולהפך: באתר איטי או כזה שמחזיר שגיאות שרת – המגבלה תרד, וייסרקו פחות דפים.

- הגדרות קצב הסריקה ב-Search Console – גוגל נענים לבקשות של בעלי האתר להקטין את קצב הסריקה, אבל הם לא ייענו בהכרח לבקשות להגדיל את קצב הסריקה.

- מגבלות הסריקה של גוגל – גם המשאבים של גוגל מוגבלים, ועם קרוב ל-4.2 מיליארד דפים באינטרנט (נכון למועד כתיבת שורות אלה), גוגל נאלצים לחסוך.

ביקוש לסריקה – לרוב גוגל מנסים להתאים את הסריקה למאפיינים הייחודיים של האתר, בהם מספר הדפים, תדירות עדכון התוכן, איכות התוכן והרלוונטיות שלו בהשוואה לאתרים אחרים. הביקוש מושפע מכמה גורמים:

- "מלאי נתפס" – אם בעלי האתר לא ינחו את רובוט הסריקה של גוגל להתעלם מדפים מסוימים, גוגלבוט ינסה לסרוק את כל האתר או לפחות את רובו. אבל אם הסריקה מתבזבזת על דפי שגיאה, תכנים משוכפלים וכדומה, תקציב הסריקה של גוגל יתכלה לשווא. ברכיב הזה קל יחסית לשלוט באמצעות איחוד דפים, חסימת דפים שאין להם ערך לגולש ועוד.

- פופולריות – אתרים ודפי אתר פופולריים ייסרקו בתדירות גבוהה יותר.

- חוסר פעילות – גם מסמכים רדומים נסרקים בתדירות גבוהה כדי לקלוט ולעדכן שינויים.

- העברות אתר – שינויי כתובות URL יכולים גם הם להגדיל את הביקוש לסריקה.

בשורה התחתונה, הדרך היחידה להגדיל את קצב הסריקה של גוגל היא באמצעות הגדלת קיבולת הסריקה ושיפור הפופולריות והרלוונטיות של התוכן באתר.

Indrid__Cold from Halifax, Canada, CC BY-SA 2.0 <https://creativecommons.org/licenses/by-sa/2.0>, via Wikimedia Commons

איך לשפר את יעילות הסריקה?

ניהול המלאי של כתובות ה-URL: תחשבו על סופרמרקט ענק שבו כל המדפים ריקים, האם תטריחו את עצמכם לקצה השני בתקווה שתמצאו מוצר זמין כלשהו? סביר להניח שלא. גוגלבוט נוקט בגישה דומה: אם תקציב הסריקה מתבזבז על סריקה של תכנים לא רלוונטיים, הוא כנראה יתייאש בשלב מסוים ויפסיק לבדוק את יתר כתובות ה-URL באתר, וגם לא ישקול להגדיל את תקציב הסריקה.

יש כמה דרכים לאותת לגוגל על הרלוונטיות של כתובות האתר וכך לשלוט ביעילות הסריקה:

- לאחד תכנים כפולים

- לחסום כתובות URL שאין כל סיבה לקדם אותם בגוגל, גם אם יש להם תפקיד כלשהו בחוויית המשתמש. (למשל דפי תודה והרשמה לאתר, גרסאות של אותו דף במיון או בסינון שונה וכדומה). את החסימה יש לעשות באמצעות robots.txt או הכלי להגדרת פרמטרים ב-Search Console. חסימת הדפים באמצעות noindex אומנם תמנע מהצגתם בתוצאות החיפוש, אבל לא תייעל את תקציב הסריקה של גוגל, מכיוון שכדי לסרוק את התגית צריך קודם כל לסרוק את הדף…

- למחוק דפים שנמחקו לצמיתות, כך שיחזירו סטטוס שגיאה 404 או 410

- להסיר שגיאות מסוג Soft 404

- לעדכן מפות אתר XML

- להימנע משרשראות של הפניות.

בנוסף, שיפור מהירות האתר ומעקב אחר הסריקה, זיהוי מוקדם של בעיות וטיפול בהן, יכולים גם הם לייעל את הסריקה של האתר.

עוד תשובות לשאלות נפוצות על הקשר בין תקציב הסריקה לקידום בגוגל:

האם הסריקה משפיעה על הקידום בגוגל?

תנאי בסיסי להופעת דף כלשהו בתוצאות החיפוש בגוגל הוא, כמובן, סריקה שלו בידי גוגלבוט. אבל עצם הסריקה לא מבטיחה שהדף יאונדקס או יופיע במיקומים גבוהים בתוצאות החיפוש.

האם מהירות האתר ושגיאות משפיעות על תקציב הסריקה?

ככל שהאתר בריא יותר הוא ייסרק מהר יותר, ואתר מהיר ונטול שגיאות הוא סימן לבריאות השרת. ולהפך: אם האתר נטען לאט או מחזיר הרבה שגיאות שרת (5xx), כך הוא ייסרק לאט יותר. גם למהירות שבה האתר מתרנדר יש חשיבות בייעול תקציב הסריקה.

האם היררכיית האתר משפיעה על הסריקה ועל הקידום בגוגל?

גוגל מאשרים שדפים הנמצאים במקום גבוה יותר בהיררכיית האתר ומקבלים קישורים מדף הבית ייסרקו לעיתים קרובות יותר. אבל אין קשר בין תדירות הסריקה לבין המיקומים בגוגל.

האם עדכון התוכן יזרז את האינדוקס?

גוגל, לטענתם, עיוורים לוותק התוכן, והמדד היחידי מבחינת מנוע החיפוש הוא איכות התוכן. מכאן שאין (בהכרח) יתרון לתוכן ותיק על פני תוכן חדש, וגם עדכון תוכן באופן מלאכותי ובלי הצדקה לא ישפר את מעמדו בגוגל.

לא בטוחים אם האתר שלכם נסרק במלואו? רוצים לייעל את תקציב הסריקה? נשמח לעזור.