robots.txt הוא קובץ טקסט שאומר לרובוטי הסריקה של מנועי החיפוש אילו חלקים באתר פתוחים לסריקה ומאילו דפים ותיקיות יש להתעלם. גוגל ומנועי החיפוש העיקריים לרוב יכבדו את ההנחיות המופיעות בקובץ robots.txt, בוטים מהסוג המרושע – לא בהכרח.

לא כל האתרים חייבים robots.txt ולקובץ השפעה ישירה על קידום האתר בגוגל. אבל במקרים מסוימים הוא יכול לעזור לייעל את תקציב הסריקה.

איך נראה קובץ robots.txt?

User-agent: [שם הרובוט]

Disallow: [התיקייה או דפי האתר שרוצים לחסום]

Sitemap: [כתובת מפת האתר]

קובצי robots.txt לדוגמה:

User-agent: *

Disallow: /

בדוגמה הזאת מנחים את כל רובוטי הסריקה לא לסרוק את כל הדפים באתר (כולל את דף הבית).

User-agent: Googlebot

Disallow: /folder/

כאן מנחים רק את רובוט הסריקה של גוגל לא לסרוק את כל כתובות ה-URL תחת התיקייה הספציפית הזאת.

User-agent: *

Disallow:

כל רובוטי הסריקה יכולים לסרוק את כל דפי האתר, כולל קבצים ומשאבים.

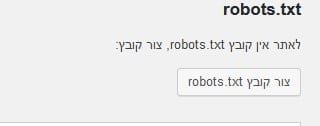

איך לבנות קובץ robots.txt

- את הקובץ אפשר לבנות באמצעות notepad ולשמור אותו כ-txt

- את הקובץ יש להעלות ל-root directory. כלומר, הכתובת שלו צריכה להיות com/robots.txt (ולא Robots.txt או וריאציה אחרת).

- באתרי וורדפרס אפשר לבנות ולערוך קובץ באמצעות התוסף Yoast SEO (כלים > עריכת קבצים > txt)

המלצות לשימוש נכון ב-robots.txt

רוב האתרים יכולים להסתדר בלי robots.txt, מכיוון שלרוב גוגל (ומנועי חיפוש אחרים) ידעו לסרוק ולאנדקס את כל התכנים החשובים באתר ולהתעלם מדפים ריקים או כפולים גם בלי הקובץ. אבל, יש כמה נסיבות שבהן אפשר להשתמש בקובץ robots.txt:

- כדי לחסום סריקה של דפים או תיקיות פרטיות – אם באתר יש דפים או תיקיות שלמות שרוצים לחסום ממנועי חיפוש ומשתמשים רנדומליים – למשל, דפים בשלבי פיתוח, דפים הדורשים הרשמה לאתר וכדומה – אפשר להיעזר בקובץ רובוטס כדי לחסום את הגישה שלהם לרובוטים וזחלנים למיניהם.

- כדי למנוע סריקה של קובצי מדיה – דפי אינטרנט לרוב אפשר לחסום באמצעות הוספת תגית מטא רובוטס נואינדקס (Meta Robots="noindex"), המורה לרובוטי הסריקה לא לאנדקס דפים ספציפיים. אבל קובצי מדיה כמו PDF, וידאו, אודיו וכדומה אפשר לחסום דרך רובוטס.

- באתרים גדולים במיוחד – אם רובוט הסריקה של גוגל לא סורק ולא מאנדקס את כל דפי האתר, אפשר להשתמש בקובץ רובוטס כדי לייעל את תקציב הסריקה, לכוון את גוגל לסרוק את הדפים החשובים ולמנוע מהם לסרוק דפים אחרים.

ניתן להשתמש בקובץ גם כדי למנוע סריקה של משאבים כמו סקריפטים, גיליונות סגנון ותמונות לא חשובות, בתנאי שחסימה שלהם לא תפגע בדרך שגוגל סורק את תוכן האתר ומבין אותו.

חשוב לציין שחסימה באמצעות קובץ רובוטס לא תמנע לחלוטין מדפי אתר להופיע בתוצאות החיפוש בגוגל, מכיוון שרובוט הסריקה של גוגל יכול לאנדקס דפים גם בלי לבקר בהם. לכן, אם רוצים להסתיר תוכן כלשהו ממנועי חיפוש, מומלץ להשתמש בחלופות אחרות כמו הוספת תגית noindex או הגנה באמצעות סיסמה. אבל אין לחסום דפים באמצעות noindex ו-robots.txt במקביל – החסימה באמצעות רובוטס תמנע מגוגל לראות את ההוראה לא לאנדקס את הדף.

אזהרות

robots.txt הוא כלי חשוב, אבל הוא גם כלי קיצוני. טעות הקלדה אחת יכולה להוביל למשבר SEO.

דוגמאות:

תרחיש 1:

רציתם לחסום את שאילתות החיפוש באתר והוספתם את הפקודה:

Disallow: /*q

התוצאה – חסמתם את כל הדפים שיש בהם q בכתובת ה-URL, כמו למשל:

/trivia-quiz/

/android-q/

/quinoa-recipes/

הפתרון – להוסיף את הסימן /

Disallow: /*q/

תרחיש 2:

חסמתם את הגישה לכל התמונות, הסקריפטים וגיליונות הסגנון.

התוצאה – מנעתם מגוגל לפענח את תוכן האתר ולהעריך את האיכות והרלוונטיות שלו ופגעתם בקידום שלו בגוגל.

הפתרון – לא לחסום משאבי JavaScript ו-CSS.

תרחיש 3:

חסמתם את הגישה לקובץ robots.txt בגלל שגיאת שרת.

התוצאה – גוגל עלול לא לסרוק את כל האתר.

הפתרון – לוודא שהקובץ נגיש ומחזיר סטטוס תקין (200) או סטטוס שגיאה (404).

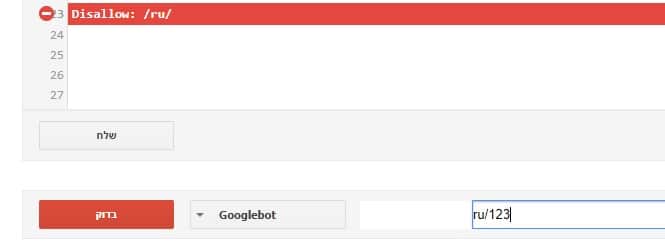

איך לבדוק שגיאות בקובץ robots.txt?

דפים ספציפיים אפשר לבדוק באמצעות בודק robots.txt של גוגל.

אם ה-URL חסום באמצעות הקובץ, תופיע הודעת שגיאה ותצביע על הסיבה לחסימה.

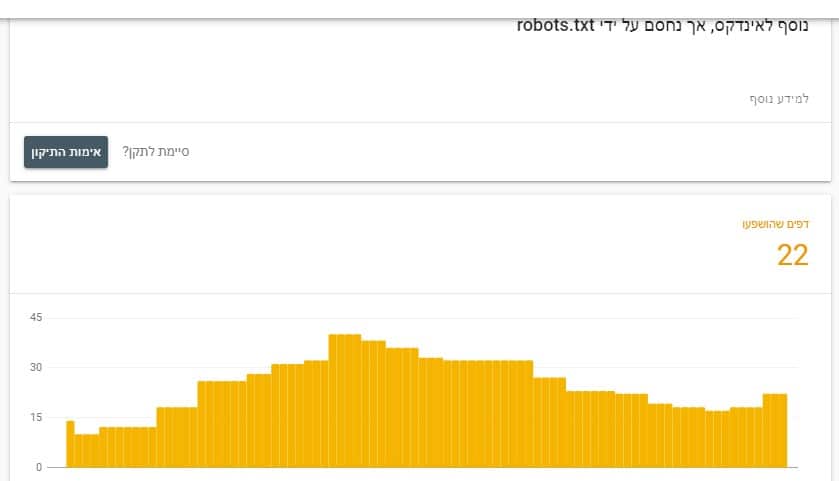

כמו כן, שגיאות robots.txt יופיעו בדו"ח כיסוי ב-Google Search Console, ומומלץ לעקוב אחריהן מפעם לפעם.

הודעת השגיאה "נוסף לאינדקס, אך נחסם על ידי robots.txt" מציגה את הדפים שממשיכים להופיע בתוצאות החיפוש, למרות החסימה ב-robots.txt.

אם המטרה הייתה להסיר אותם מתוצאות החיפוש, יש להסיר את החסימה מ-robots.txt ולהוסיף להם תגית noindex.

אם הם נחסמו בטעות – יש להסיר את החסימה ולשלוח לגוגל בקשה לאימות התיקון.

עדכונים

מאז ספטמבר 2019 גוגל הפסיקו לתמוך במספר פקודות דרך robots.txt, בהן noindex, nofollow ואחרות. לקריאה על הידיעה: https://nekuda.co.il/google-ends-noindex-robots-txt/