גוגל התחילו לשלוח התראות לאתרים שחוסמים JavaScript ו-CSS ומזהירים אותם שהמיקומים שלהם צפויים להיפגע מהחסימה.

מאתמול גוגל שלחו הודעות דרך ה-Search Console (השם החלופי ל-Google Webmaster Tools) לאתרים שחוסמים את קובצי ה-CSS וה-JS.

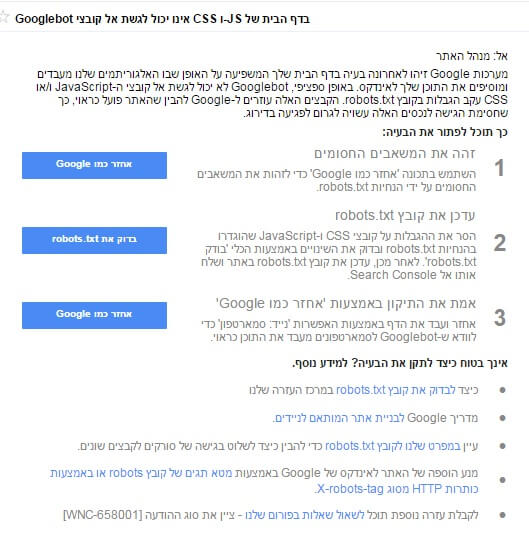

נוסח ההודעה אומר ש"Googlebot לא יכול לגשת אל קובצי ה-JavaScript ו/או CSS עקב הגבלות בקובץ robots.txt." ומוסיף אחר כך "שחסימת הגישה לנכסים האלה עשויה לגרום לפגיעה בדירוג."

האזהרות לגבי פגיעה בדירוג אמנם אינן חדשות, אבל עד עכשיו לא נשלחו התראות הרשמיות מ-Search Console בנושא הזה. כבר באוקטובר 2014 גוגל עדכנו את ההנחיות למנהלי אתרים והזהירו שחסימת קובצי JavaScript ו-CSS יכולה להוביל לפגיעה בדירוג, וההתראות מעבירות את המסר בצורה ברורה וחד-משמעית.

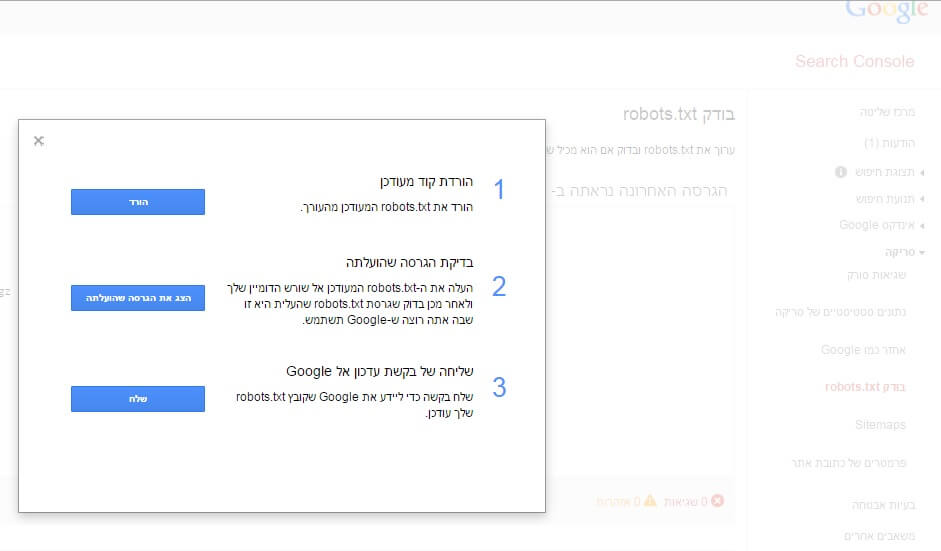

כך נראית ההודעה של גוגל, והיא כוללת גם הסברים איך לתקן את הבעיה:

בקצרה, כדי להסיר את החסימה של קובצי CSS ו-JS:

1. לבדוק אילו משאבים חסומים דרך אחזר כמו גוגל (fetch as Google).

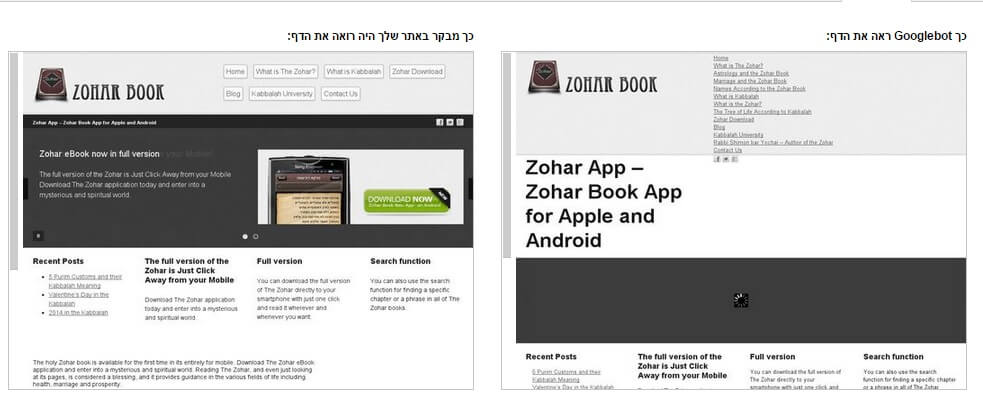

בחירה באחזור ועיבוד תציג את האתר כפי שרובוט הסריקה של גוגל רואה אותו:

2. להסיר את החסימה מקובץ robots.txt

מי שאינו מומחה בצדדים הטכניים, יכול פשוט להוסיף את שורות הקוד האלה לקובץ:

User-Agent: Googlebot

Allow: /*.js*

Allow: /*.css*

3. לבדוק שהקובץ תקין דרך בודק robots.txt ב-Search Console

4. להעלות את הקובץ המעודכן לאתר ולעדכן את גוגל דרך ה-Search Console.

5. לבדוק את התיקון ולאמת אותו דרך אחזר כמו גוגל.